Det tredje HanDiRob-møde #2

Derefter gav Andreas Sørensen, Rasmus Junge og Daniel Holm en detaljeret præsentation af udviklingen af den mobile enhed i form af hardware og software.

1.Hardware

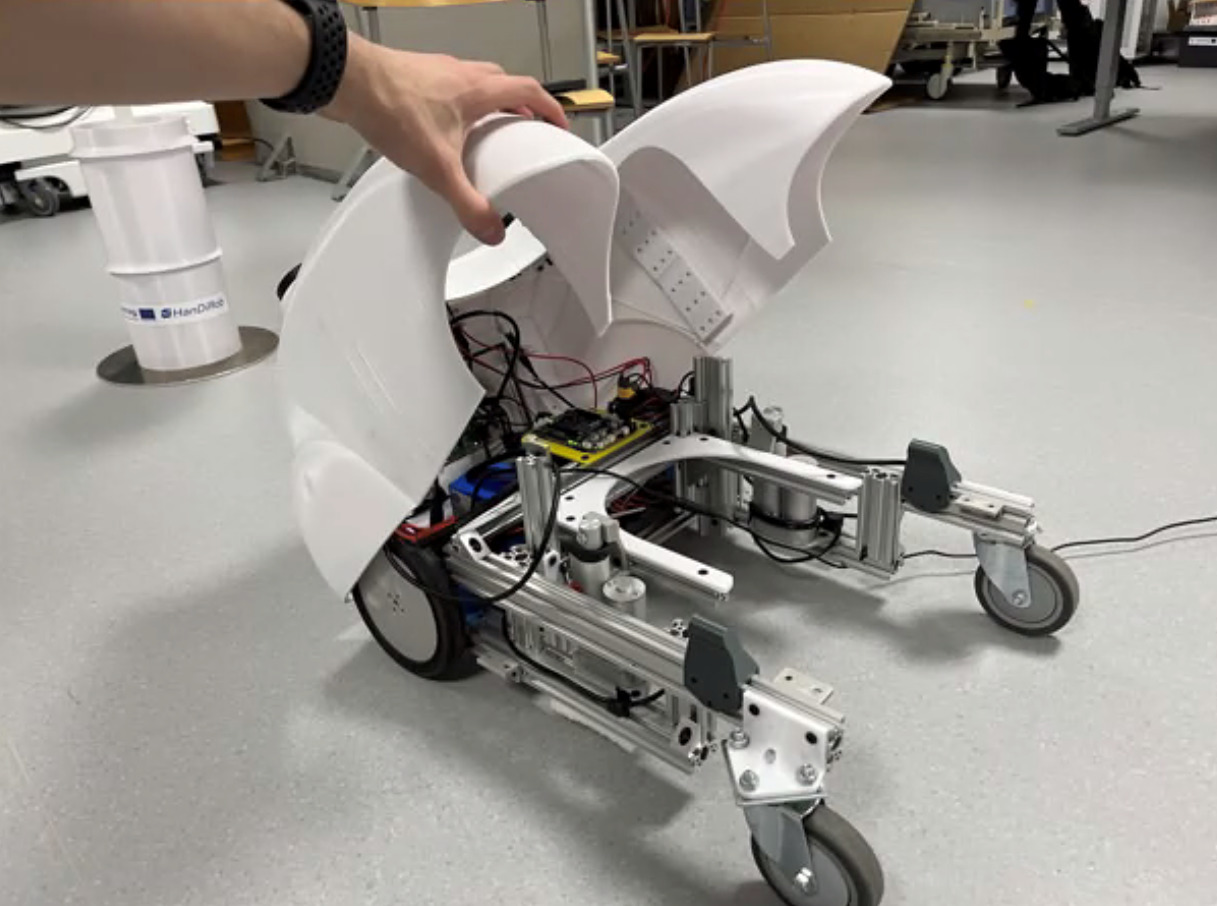

Team SDU genoptrykte den mobile enhedens hus. Meget er blevet ændret strukturelt, f.eks. er der tilføjet mange monteringshuller til fremtidig udvidelse, så forhåbentlig behøver kassen ikke at blive trykt på ny. Den nye trykte kasse er meget bedre og mere stabil end den tidligere.

Der er også monteret hængsler, så man kan åbne kassen ved at løfte den bagfra. Det siges at fungere meget godt og er ret stabilt.

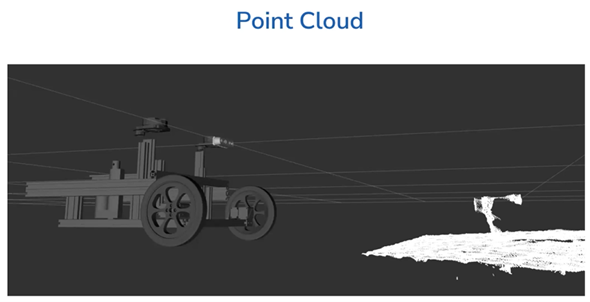

Desuden blev der anvendt en ny lidar (en forkortelse for “light detection and ranging”). En lidar er en radar, der arbejder med lys i stedet for radiobølger. Lidaren bruges til at registrere omgivelserne, mere præcist til at genkende og kategorisere objekter. I HanDiRob-projektet spiller dette en stor rolle, da den mobile enhed kun kan genkende vægge og forhindringer med dens hjælp og dermed navigere selv. SDU-holdet forklarede, at de bruger en ny lidar af typen RP-A1 til HanDiRob, da den forrige var støjende og påvirket af lys. Holdet har valgt RP-A1 lidar som et alternativ, som har en højere rækkevidde og opløsning og koster det samme som sin forgænger. Mens den gamle kun havde en rækkevidde på 3 m, kan den nye registrere objekter i en afstand på op til 6 m.

Desuden anvendes et dybdekamera som supplement til lidaren. Da lidaren er monteret på toppen af den mobile enhed, kan alt under denne højde desværre ikke registreres. Dybdekameraet registrerer alle mindre objekter, der ikke kan registreres af lidarkameraet.

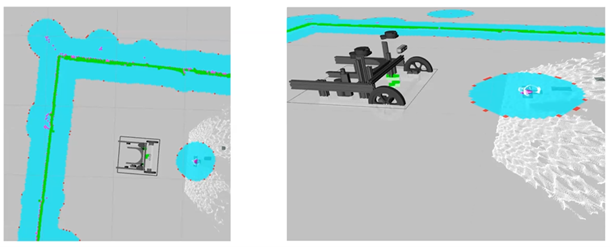

Billedet viser et billede af dybdekameraet. Den kan registrere koppen foran robotten, selv om den står på jorden, hvilket lidar ikke kan registreres af lidaren. Gennem samarbejdet mellem lidaren og dybdekameraet registreres ikke kun vægge, men også forhindringer, der ikke er i lidarens højde. Den blå zone på billedet nedenfor angiver det område, som den mobile enhed skal undgå under kørslen.

2. Software

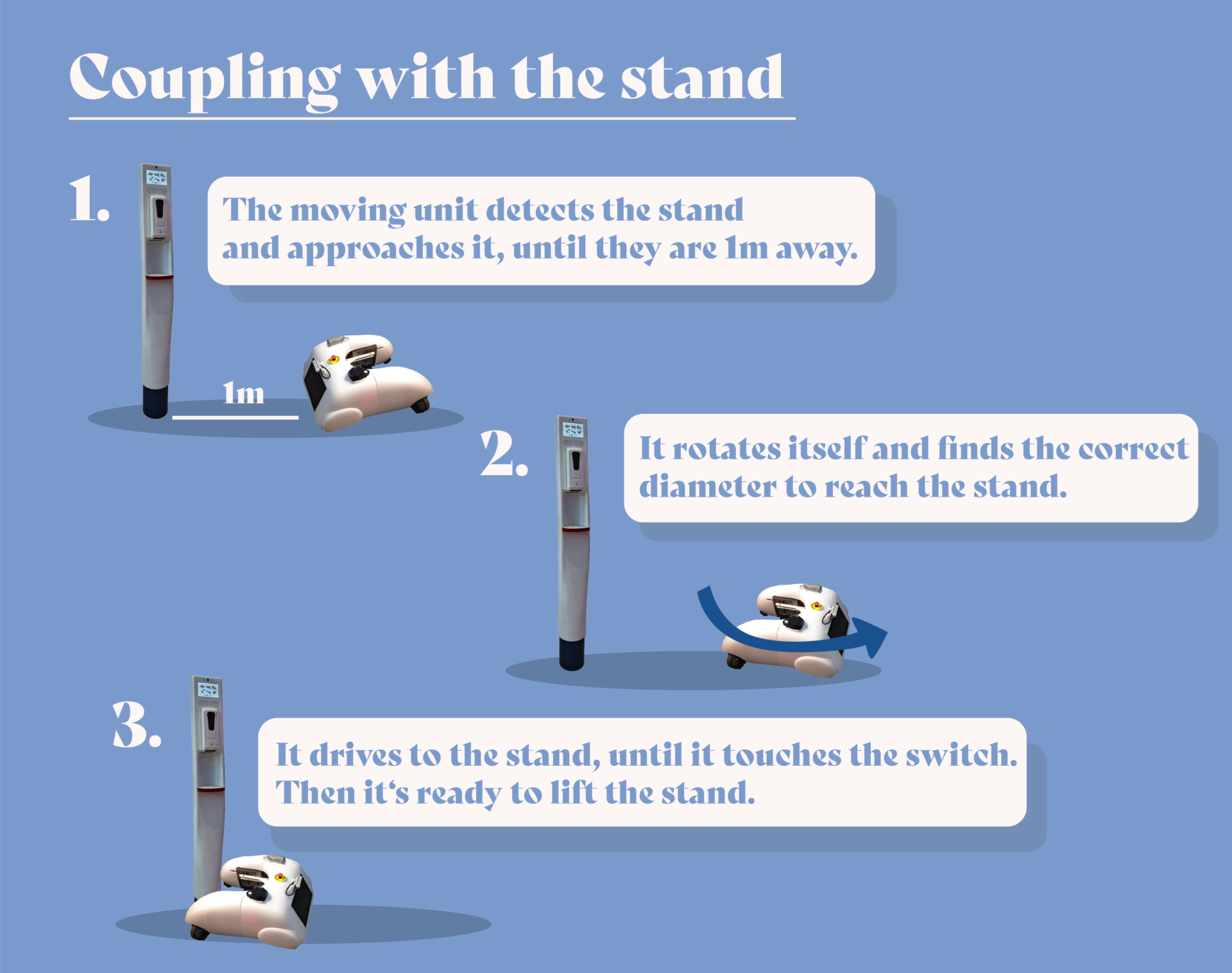

Den mobile enhed skal kunne genkende personer og køre hen til dem. Holdet har også gjort fremskridt i denne henseende. Ved hjælp af “Intel RealSense” kan robotten registrere mennesker med stor nøjagtighed, i hvilken retning de står, og i hvilken retning de bevæger sig. Når robotten opdager personer, lokaliserer den dem på sit interne kort. Den samme algoritme anvendes også til at genkende den stationære enhed. Den mobile enhed skal kunne registrere den stationære enhed, køre hen til den og koble sig sammen med den. På nuværende tidspunkt kan robotten registrere den stationære enhed i en afstand af ca. 5 m fra den.

Endelig blev udviklingen i Behavior Tree og grænsefladen drøftet. Med hensyn til robottens adfærd er SDU-holdet i øjeblikket ved at implementere Behavior Trees, en grafisk programmering, hvor robottens adfærd kan udvikles ikke kun hurtigt, men også ned til det abstrakte niveau. Grænsefladen er implementeret i form af et ansigt med to øjne. Holdet forklarede, at dette giver dem mulighed for at udtrykke følelser rimeligt godt og fremkalder gensidig øjenkontakt. Øjenkontakt spiller en vigtig rolle for at tiltrække folks opmærksomhed og formidle budskaber.

Hvorfor er øjenkontakt eller blik så vigtigt i HRI (Human Robot Interface)? Oskar Palinko, assisterende professor ved SDU, forklarer denne sammenhæng nedenfor:

Tekst og grafik: Jihyun Lee

HanDiRob er støttet af Interreg Tyskland-Danmark med midler fra Den Europæiske Fond for Regionaludvikling. Få mere at vide om Interreg Tyskland-Danmark

på www.interreg5a.eu